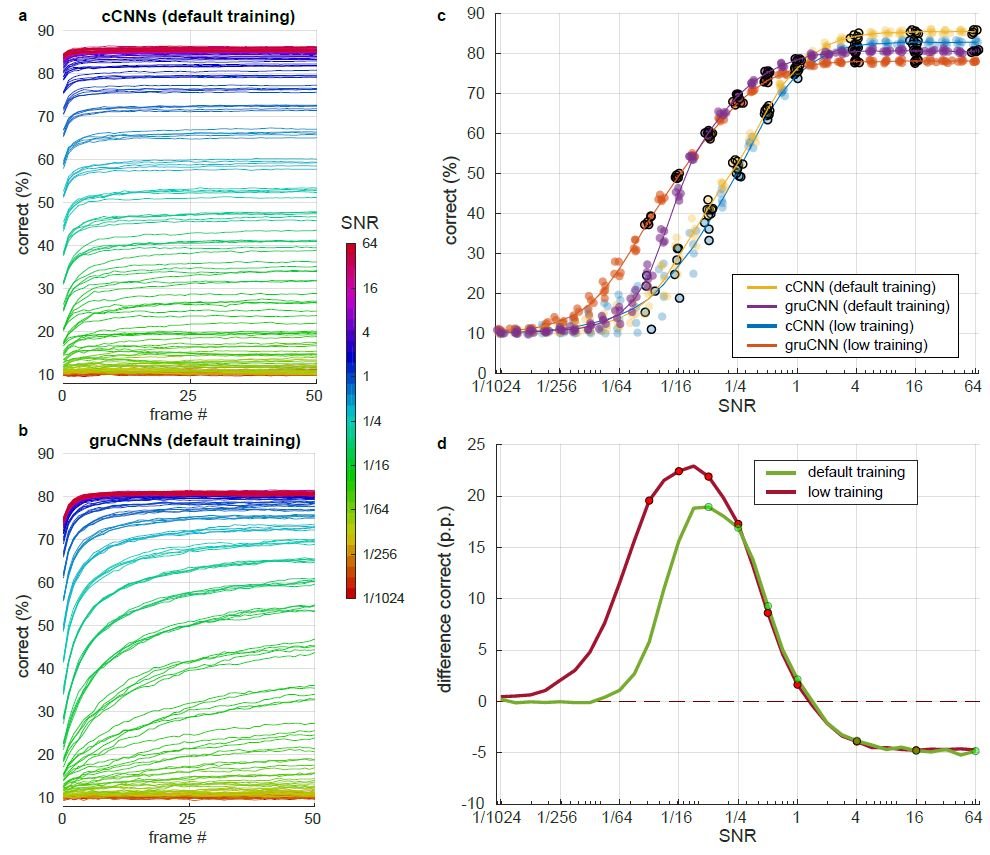

Технология классических конволюционных нейросетей – или как их называют еще cCNN – представляет собой основную базу алгоритмов и скриптов, благодаря которой различные нейросети могут анализировать визуальную информацию, правильно ее обрабатывать и заполнять недостающие фрагменты. Будучи технологией, достаточно распространенной на всех уровнях, тем не менее она обладает рядом существенных ограничений, которые не позволяют ей назваться по-настоящему эффективной и полезной в применении в действительно сложных задачах. К примеру, в процессировании визуальной информации для искусственного интеллекта автономных автомобилей или криминалистических нейросетей.

Именно по этой причине талантливый исследователь в области нейронауки Тилль Хартман, являющийся профессором нейронауки при Гарвардском Университете, решил несколько улучшить данную технологию нейросетей, сделав ее более похожей на человека. В том смысле, чтобы научить ее думать и визуализировать пространство так, как это делает человеческий мозг – ведь заполнять недостающую визуальную информацию чаще всего приходится при неидеальных, а часто и проблематичных условиях.

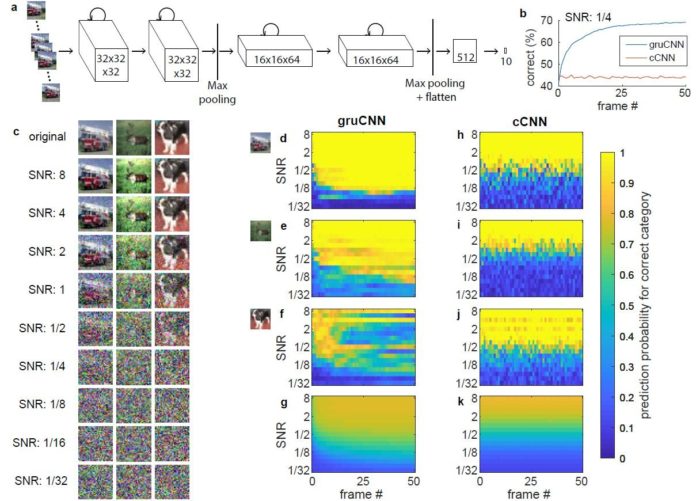

Он обратил внимание на то, как функционирует визуальная кора головного мозга, отметив ее обратно-прямой тип визуализации и обработки визуальной информации. Соединившись с командой по программному инжинирингу, он сумел представить так называемые возвратные конволюционные нейросети, которые практически полностью повторяют процесс обработки и восприятия визуальной информации человеческого мозга, таким образом гораздо эффективнее заполняя пустое логическое пространство имеющегося отображения.

Причем эти возвратные CNN обладают поистине грандиозным уровнем работы даже при самых мешающих восприятию обстоятельствах и условиях – к примеру, новая система нейросетей была протестирована с целью установить, насколько хорошо она сможет дополнить размытое изображение, с чем она прекрасно справилась уже спустя несколько секунд анализа.