Компания NVidia действительно знает, как удивлять своих поклонников и всех ценителей современных графических ускорителей – дело в том, что уже сейчас на рынке стали доступны к покупке новые графические чипы NVidia GTX 1650 и 1660 Ti для ноутбуков. И релиз данных не вполне запланированных чипов просто не мог не удивить пользователей, поскольку те вообще не ожидали, что компания вот так быстро выдвинет нечто альтернативное современным недорогим чипам. Сами модели GTX 1650 для настольных решений и GTX 1660 Ti для мобильных реализованы на той самой платформе Turing, на которой реализованы видеокарты текущего поколения NVidia RTX. Однако, в чем же подвох?

А подвох тут заключается в том, что хоть новые графические чипы и построены на платформе Turing, они не обладают полноценной поддержкой технологии RTX и DSLL – из этого вытекают вполне понятные и логичные технические ограничения по эксплуатации этих карт в игровых и графических приложениях. Во всем остальном новые чипы призваны конкурировать с чипами прошлого поколения, такими как GTX 1060 и GTX 1070. Впрочем, большая часть пользовательской аудитории настроена к этому скептически.

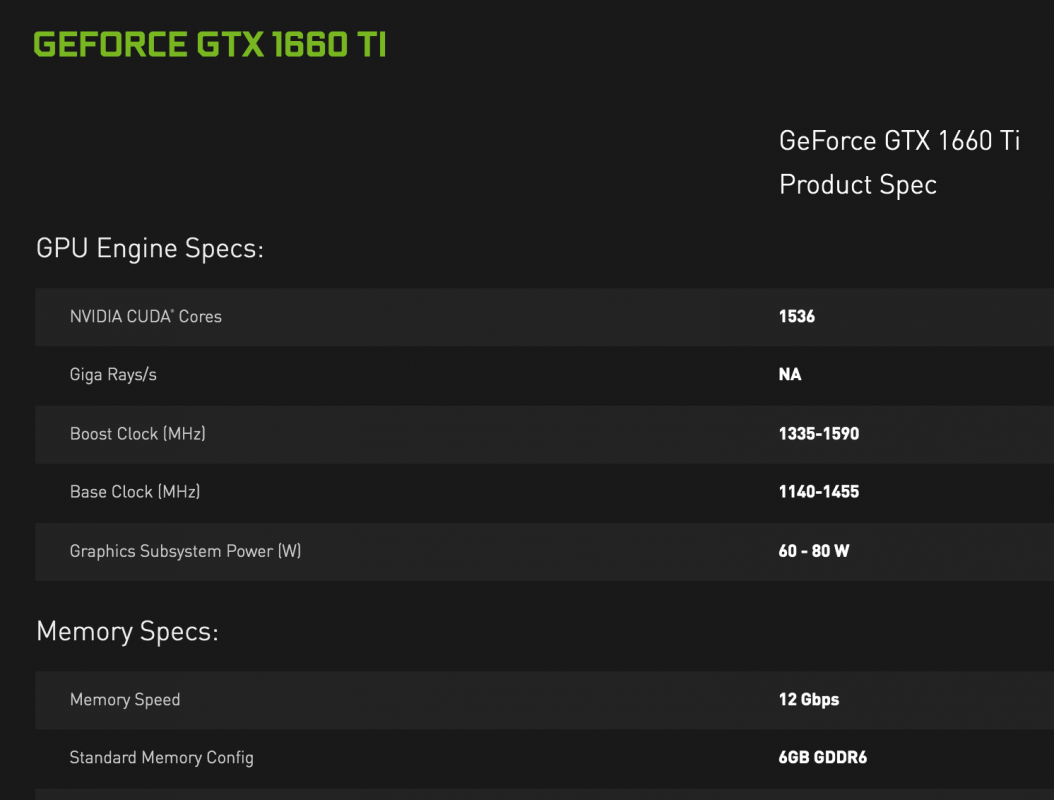

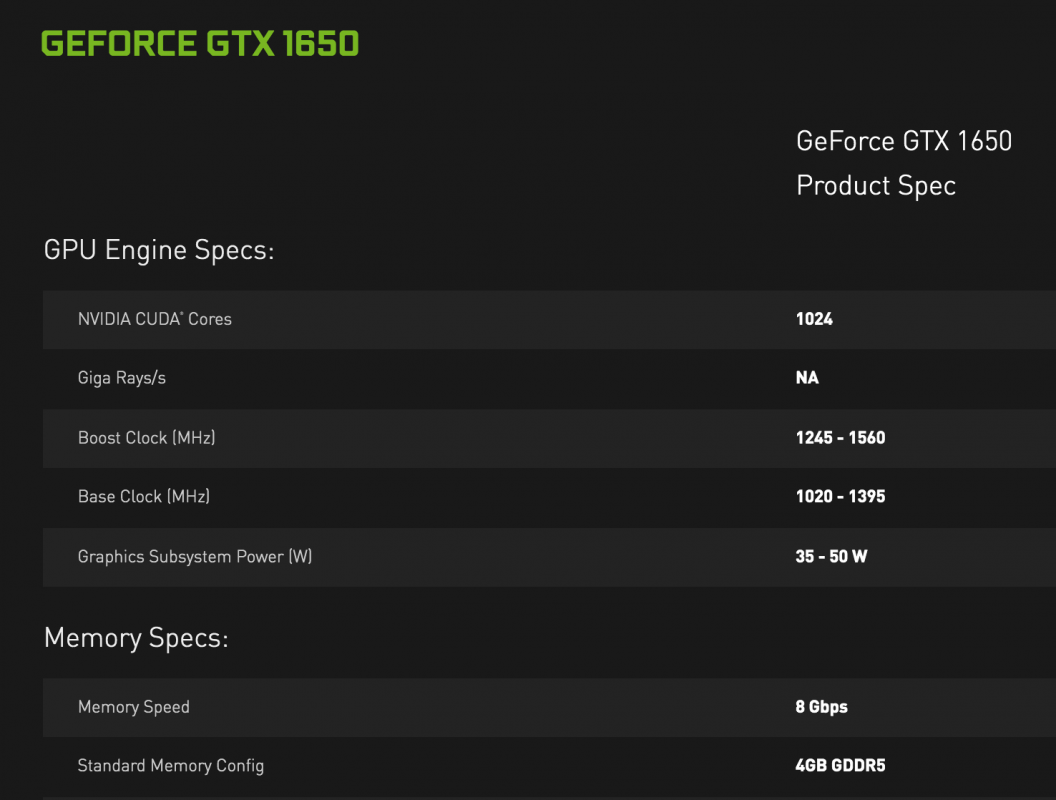

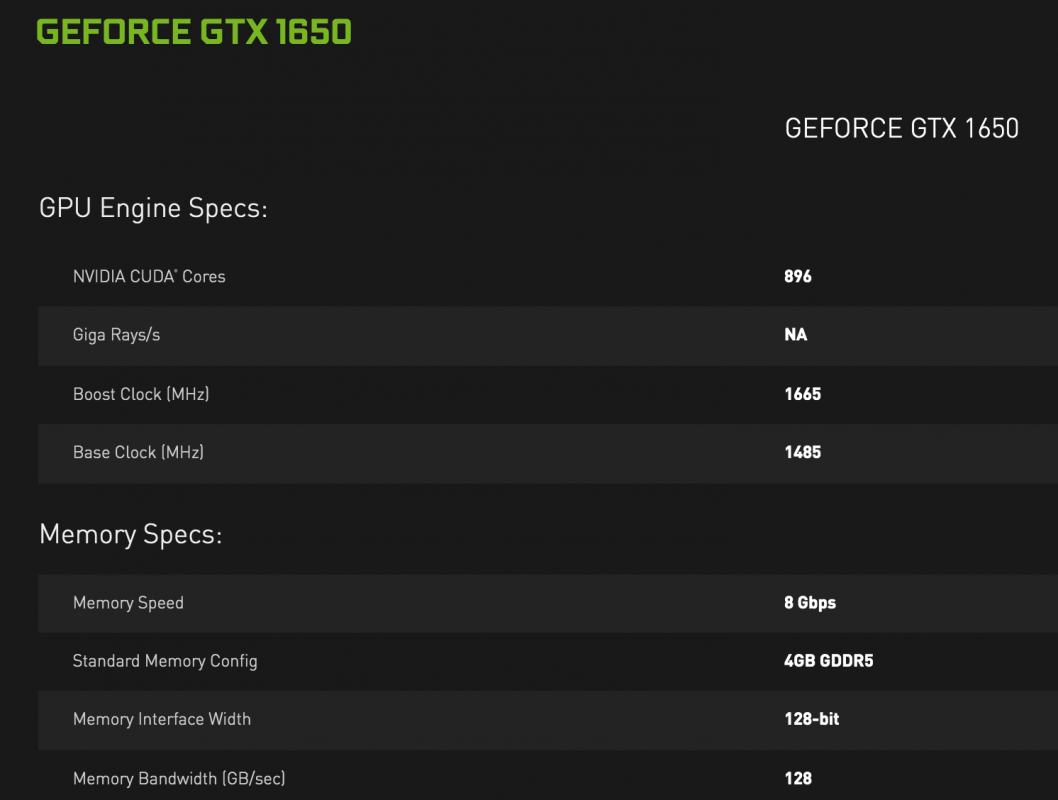

Потому как достаточно просто обратить внимание на проиллюстрированные технические возможности обеих чипов. Конкретно модель GTX 1650 обладает 4 Гб видеопамяти формата GDDR 5, начальной частотой ядра в 1,485 и пропускной способностью в 128 Гб в секунду – а это мало как отличает ее от той же GTX 1060, по крайней мере, на бумаге. Тем не менее, чип призван стать более экономической и производительной заменой аналогичному чипу прошлого графического поколения NVidia.

Кстати, об экономии – в этом отношении инженеры NVidia действительно постарались, так как у модели GTX 1650 совсем не наблюдается никакого внешнего разъема питания, что означает крайне низкий показатель тепловыделения. Означенные производителем технические характеристики показывают, что графическая подсистема питания потребляет от 35 до 50 Ватт, что является рекордно низким показателем даже для NVidia с ее достаточно мощными решениями.